À quoi servent les Agent Skills d’OpenAI ?

2026 est déjà présentée comme « l’année des agents » : le vrai frein n’est plus de générer du code, mais de répéter le contexte, d’orchestrer les étapes et de tout vérifier. Dans ce contexte, openai formalise des « Agent Skills » dans Codex, pour rendre les agents plus extensibles, modulaires et prévisibles.

C’est quoi, exactement, un « Agent Skill » ?

Un Agent Skill, c’est un paquet standardisé (instructions + ressources + scripts) qu’un agent peut repérer et charger à la demande. L’idée est simple : au lieu de réexpliquer un mode opératoire à chaque requête, on le met en boîte, puis on le réutilise.

Concrètement, un skill s’articule autour d’un fichier SKILL.md. Il contient des métadonnées en langage de sérialisation YAML (YAML) — notamment un nom et une description — puis des instructions en Markdown. Autour, on peut ajouter des dossiers optionnels : scripts (automatisation), references (exemples, docs), assets (gabarits, fichiers utiles). OpenAI décrit ce format et sa logique de chargement « à la demande » dans la documentation Codex dédiée aux skills : documentation OpenAI sur les skills Codex .

Le point clé, dans les faits : ce n’est pas « un prompt ». C’est une brique réutilisable, versionnable, partageable, qui encode un flux de travail.

À quoi ça sert : résoudre trois problèmes qui reviennent avec les agents

Premier irritant : la répétition et le « prompt spaghetti », ces consignes qui s’allongent jusqu’à devenir ingérables. En pratique, les skills encapsulent les procédures, ce qui évite de redire « comment on fait ici » à chaque demande.

Deuxième problème : le coût du contexte et des jetons (tokens), c’est-à-dire l’unité de texte facturée et ingérée par le modèle. Codex applique une logique de « divulgation progressive » : au départ, l’agent ne charge que le nom et la description des skills, puis n’ouvre le contenu complet que si c’est pertinent.

Troisième point : la fiabilité opérationnelle. Les instructions servent au raisonnement et au déroulé, tandis que les scripts peuvent prendre en charge des étapes fragiles (commandes, manipulations de fichiers, vérifications répétitives), avec moins d’aléas qu’une exécution improvisée.

Mini-exemples côté entreprise : préparer une demande de fusion (pull request), en respectant votre modèle interne et vos règles de revue. Ou encore appliquer vos conventions de nommage et lancer la batterie de tests, puis trier les erreurs selon votre procédure de diagnostic.

Pour cadrer cette recherche de fiabilité, OpenAI pousse aussi une approche d’évaluation des skills, avec des critères de réussite et des tests d’activation explicites et implicites : billet OpenAI sur l’évaluation des skills .

Dans Codex, la mécanique repose sur le déclenchement et les périmètres

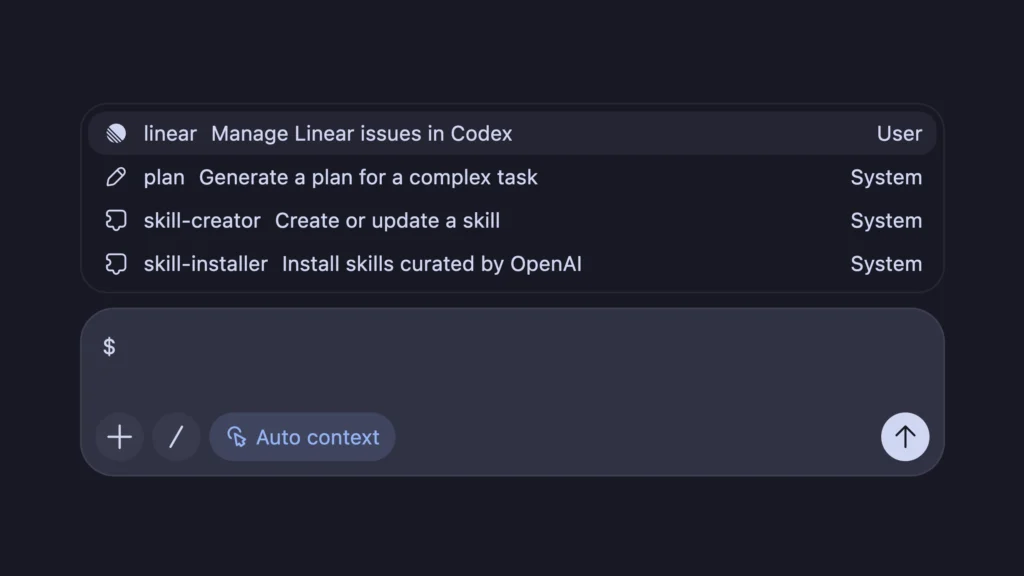

Un skill peut se déclencher de deux façons. Soit explicitement, quand on le mentionne (par exemple via une commande dédiée ou un préfixe), soit implicitement, quand Codex estime que la requête correspond à la description.

Cette distinction compte : l’implicite fait gagner du temps, mais impose une description bien écrite. Dans ce système, la description n’est pas du marketing. C’est un mécanisme de routage qui détermine si l’agent va charger le bon skill au bon moment.

Autre élément opérationnel : les emplacements, organisés en « périmètres » avec une logique de priorité. Codex gère notamment un niveau utilisateur (USER), un niveau machine/organisation (ADMIN), un niveau dépôt (REPO) et un niveau par défaut (SYSTEM). Pour une entreprise, cela permet de poser des standards globaux, tout en laissant un projet imposer ses règles, et un développeur surcharger localement si nécessaire.

Ce que ça change pour les équipes : productivité, cohérence et capitalisation

Le premier changement est culturel : on capture du savoir tacite. Conventions de code, règles d’intégration continue, listes de contrôle qualité, procédures de dépannage, tout ce qui vit d’habitude dans des messages ou dans la tête de quelques seniors.

Ensuite, la boucle « plan → exécution → raffinement » se formalise. Quand l’agent échoue ou hésite, on corrige le processus, puis on le « compile » en skill. À court terme, cela réduit le temps de cadrage et la fatigue de répétition ; à moyen terme, cela standardise et accélère l’intégration des nouveaux arrivants.

Enfin, les erreurs deviennent plus reproductibles. Si un skill se trompe, on peut le corriger comme un actif logiciel, en le versionnant et en le testant, plutôt qu’en espérant que le prochain prompt sera plus clair.

Lecture business : openai pousse un standard, et donc un marché

Derrière la nouveauté, un mouvement de plateforme se dessine. Codex devient un socle, et les skills jouent le rôle d’extensions : une façon de spécialiser l’agent sans modifier le modèle.

Dans ce contexte, un écosystème « ouvert » émerge déjà autour d’un répertoire de skills et d’outils d’installation. Vercel, par exemple, présente un « open agent skills ecosystem » qui vise la portabilité entre assistants et agents : annonce Vercel sur l’écosystème de skills .

Cela place openai dans une course aux standards. Les skills ne remplacent pas l’appel de fonctions (function calling), qui sert surtout à déclencher des outils, ni le protocole de contexte de modèle (Model Context Protocol, MCP), qui structure l’accès à des ressources et services. Ils se positionnent plutôt sur le « comment on procède », c’est-à-dire l’enchaînement, les garde-fous et la méthode.

Attention aux angles morts : limites et risques

Les Agent Skills promettent une exécution plus « industrielle », mais ils déplacent aussi la complexité vers l’organisation et la maintenance.

Points de vigilance :

- Déclenchement imparfait : faux positifs et faux négatifs existent, surtout au début ; il faut itérer sur les descriptions, les exemples et la nomenclature.

- Dette de maintenance : un process change, une interface évolue, une règle interne se met à jour ; sans propriétaire et versionnage, le skill devient vite dangereux.

- Sécurité et conformité : des scripts exécutables peuvent toucher au dépôt, à l’intégration continue et à des secrets ; il faut limiter les droits, isoler l’exécution et imposer une revue.

- Risque organisationnel : standardiser un mauvais process accélère surtout l’inefficacité ; des indicateurs doivent mesurer le gain réel et les erreurs évitées.

Conclusion

Les Agent Skills ne rendent pas l’IA « plus intelligente ». Ils la rendent plus opérable, avec moins de friction et plus de répétabilité. La promesse est solide — modularité et chargement à la demande — mais le résultat dépend surtout de la qualité des descriptions, de la gouvernance et de la maintenance, comme pour n’importe quel logiciel.