OpenAI GPT-5.1 : ce que ça change et comment l’adopter

OpenAI GPT‑5.1 : cap sur une IA plus rapide, plus fiable, plus personnalisable

OpenAI déploie GPT‑5.1, une évolution significative pour l’intelligence artificielle (IA) de conversation et de raisonnement. Au‑delà des performances, l’enjeu business est clair : une IA plus rapide sur le quotidien, plus profonde sur l’analyse, et mieux intégrée aux outils de l’entreprise.

Contexte : pourquoi cette version compte vraiment

GPT‑5.1 inaugure un duo de modèles avec routage automatique (routing) : Instant, orienté vitesse et dialogue, et Thinking, dédié au raisonnement complexe. Le raisonnement adaptatif (adaptive reasoning) ajuste l’effort de calcul à la difficulté, accélérant les tâches simples et approfondissant les cas ardus. OpenAI promet aussi une baisse marquée des erreurs factuelles, des réponses plus chaleureuses, et des préréglages de ton (presets) pour aligner l’IA sur la culture de chaque organisation. Pour OpenAI, c’est un pas vers une IA « de production » qui s’insère directement dans les flux métiers.

Ce que change GPT‑5.1 pour OpenAI et pour les entreprises

Dans les faits, GPT‑5.1 combine trois apports majeurs.

- Architecture bi‑modèle et routage automatique. Les requêtes courantes (« résume cet email ») basculent sur Instant ; les analyses (« trouve les tendances de ce tableau ») sur Thinking. L’utilisateur n’a rien à paramétrer, tout en gardant la possibilité d’imposer un mode.

- Raisonnement adaptatif. Le modèle consomme moins de calcul pour les demandes triviales et investit davantage quand la contrainte est serrée ou l’analyse multi‑étapes. Résultat : latence réduite sur le quotidien et meilleure exactitude sur les cas complexes.

- Personnalisation et fiabilité. Six préréglages de ton, réglages fins (concision, chaleur, humour, usage d’émojis), application immédiate aux conversations en cours, et nette amélioration du respect des consignes (longueur exacte, format imposé, listes numérotées, etc.).

Côté chiffres, OpenAI annonce des réponses « environ 45 à 80 % » plus fiables que les versions précédentes selon les modes et contextes. Les variantes Codex orientées code progressent aussi, avec 76 % de réussite sur la banque d’essai SWE‑bench Verified, utile pour mesurer la capacité à corriger des bugs réels ( SWE‑bench Verified ).

Les faits saillants à retenir

- Instant privilégie la vitesse et la chaleur conversationnelle, avec une fenêtre de contexte de 32 000 jetons.

- Thinking pousse l’analyse et la vérification, avec des temps de réponse plus longs et un contexte étendu (jusqu’à 196 000 jetons selon les configurations annoncées par OpenAI).

- La mise en cache d’invite (prompt caching) sur l’interface de programmation (API) s’étend jusqu’à 24 h, réduisant jusqu’à 90 % le coût des parties de prompt réutilisées.

- Côté prix API, OpenAI positionne GPT‑5.1 de manière compétitive, avec une forte décote sur les entrées mises en cache et des variantes mini pour les tâches de classement ou de résumé massif.

- Les connecteurs natifs et Zapier déverrouillent l’automatisation multi‑applications (emails, feuilles de calcul, CRM), renforçant la place de l’IA dans les workflows ( annonces et ressources OpenAI, intégrations Zapier pour ChatGPT ).

« Nous avons conçu GPT‑5.1 pour ajuster l’effort de calcul à la difficulté réelle des tâches, sans friction côté utilisateur », détaille Mira Murati, directrice de la technologie d’OpenAI, dans la communication produit. « Sur les tâches simples, vous obtenez des réponses plus vite ; sur les problèmes difficiles, le modèle prend le temps de bien faire. »

Personnalisation : un assistant qui adopte votre style

En pratique, les préréglages de ton (Default, Friendly, Efficient, Professional, Candid, Quirky) et les curseurs fins permettent d’adapter l’IA à chaque équipe. Un support client pourra activer un style chaleureux et concis ; une équipe juridique privilégiera un ton formel avec une structuration stricte. Surtout, les réglages s’appliquent immédiatement aux conversations en cours. L’IA peut même proposer d’actualiser les préférences si elle observe des demandes répétées (« sois plus concis »).

Sur la fiabilité, les progrès se voient sur les contraintes exactes. Là où d’anciens modèles rataient une consigne « exactement 50 mots », GPT‑5.1 suit la règle et contrôle la forme (tableau, JSON, titres…). C’est crucial pour les automatisations : moins de rejets en aval, moins de règles de validation ad hoc.

Sécurité et réduction des hallucinations : des garde‑fous plus solides

OpenAI indique une forte baisse des erreurs factuelles, notamment en mode approfondi. Des entraînements spécifiques sur les situations sensibles (détresse psychologique, signaux de risque) améliorent la qualité des réponses d’assistance et l’orientation vers des ressources adaptées. L’objectif est pragmatique : plus d’exactitude quand on synthétise des documents longs, et une meilleure calibration quand l’IA n’est pas certaine.

« Dans nos pilotes, la baisse des corrections humaines sur des tâches répétitives est tangible » témoigne Claire Morel, DSI d’un distributeur européen ayant testé GPT‑5.1 sur le service client. « Le tri de demandes simples part sur Instant ; pour les dossiers litigieux, Thinking documente et source mieux les décisions. »

Comment s’en servir : du pilote à la production

Commencez par cartographier vos cas d’usage et associer chaque famille au bon mode.

- Support et conversationnel à volume élevé : Instant (latence et ton).

- Analyse complexe (risques, conformité, data room, recherche) : Thinking.

- Développement logiciel, refactoring multi‑fichiers : variantes Codex.

- Classement à grande échelle, résumés standards : mini, pour optimiser les coûts.

Dans ce contexte, mettez en place des prompts de référence par métier, en réduisant les consignes contradictoires. Avec GPT‑5.1, privilégiez des instructions exactes (« 200 mots maximum », « tableau Markdown à 3 colonnes », « 3 titres de moins de 60 caractères »). Activez la mise en cache d’invite pour vos blocs stables (politiques internes, glossaires, persona) et mesurez le taux de réutilisation.

Côté intégration, les connecteurs Gmail/Calendar/Contacts et l’automatisation via Zapier ouvrent la porte à des boucles « lecture → décision → action » sans changer d’outil. Exemple : classification automatique d’emails entrants, synthèse dans un tableau, réponse type adaptée, puis création de ticket si nécessaire — le tout orchestré par l’IA.

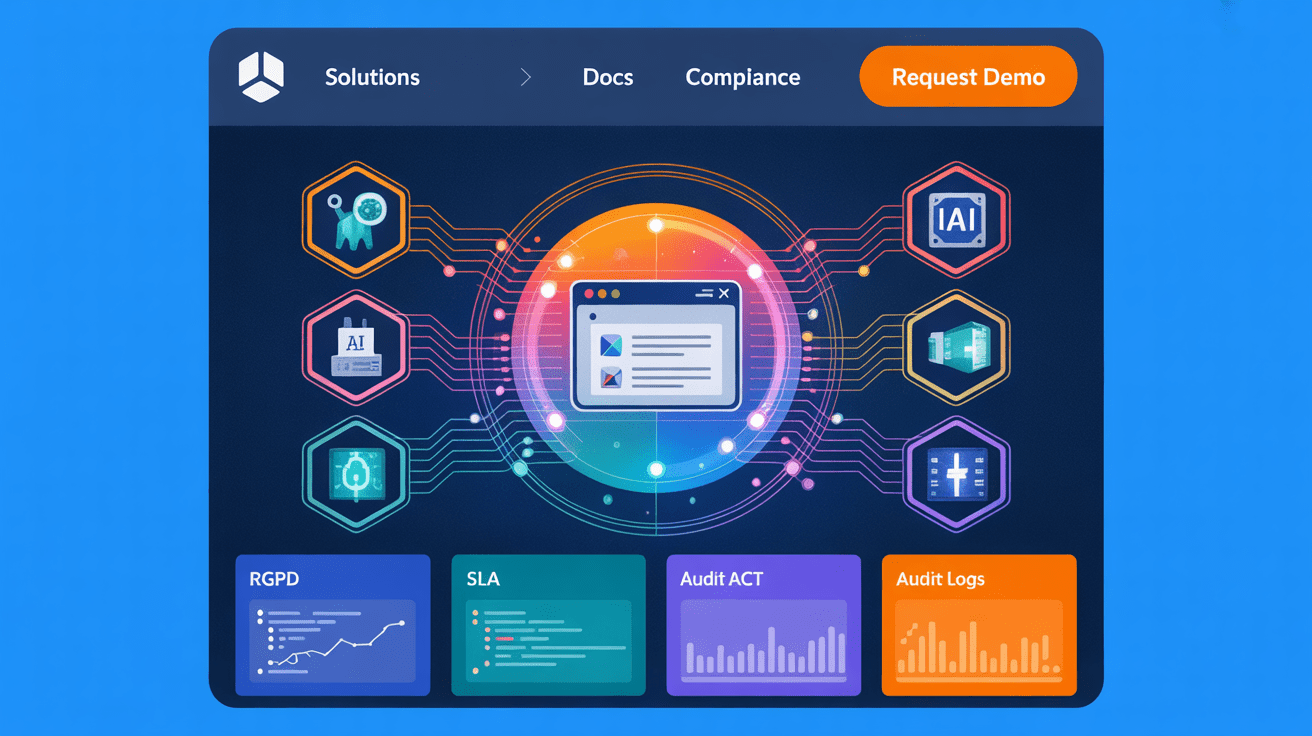

Points de vigilance pour les équipes

Avant d’industrialiser, formalisez vos garde‑fous :

- Définissez les cas nécessitant une relecture humaine systématique (juridique, RH, communication sensible).

- Logguez prompts et sorties, avec un échantillonnage pour audit qualité et conformité.

- Mesurez latence, coût par requête et taux d’erreurs par cas d’usage ; ajustez le routage manuel si besoin.

- Documentez les réglages de ton et les consignes de format pour éviter les dérives stylistiques.

Développeurs : tirer parti de l’API et des variantes Codex

Pour les équipes techniques, GPT‑5.1 apporte trois leviers. D’abord, le routage automatique simplifie l’orchestration applicative : plus besoin de règles maison pour choisir un modèle. Ensuite, la mise en cache d’invite jusqu’à 24 h permet de scinder prompts en segments stables et variables, avec une facturation d’entrée nettement réduite. Enfin, les variantes Codex progressent en robustesse outillée (application de patchs ciblés, shell contrôlé, système de fichiers virtuel), ce qui améliore la qualité des diffs et la stabilité des boucles de test.

Côté coûts, OpenAI détaille une tarification compétitive, avec une forte décote des jetons d’entrée mis en cache et un mode lot (batch) pour les charges asynchrones. L’enjeu est d’architecturer les prompts pour maximiser le taux de cache, tout en séparant clairement les contextes communs des variables par utilisateur.

« Le respect accru des contraintes change la donne pour les chaînes multi‑étapes : moins d’échec silencieux, moins de rattrapage par regex » observe Hugo Laurent, analyste indépendant en IA. « On peut oser des workflows plus longs avec moins de garde‑fous applicatifs. »

Concurrence : une bataille de spécialisations

Face à Google, la famille Gemini revendique de fortes performances sur certaines banques d’essai de raisonnement abstrait. Anthropic maintient des atouts sur la production de code conservatrice et les artefacts. Mais le positionnement de GPT‑5.1 est clair : vitesse et personnalisation côté chat, profondeur côté analyse, et un écosystème d’automatisation très large via Zapier et les connecteurs natifs. Pour les entreprises, l’arbitrage se fait cas d’usage par cas d’usage, pas « un modèle pour tout » ( présentation Gemini ).

Ce que ça change, très concrètement

- Productivité individuelle : meilleure qualité au premier jet pour la rédaction, la synthèse et la reformulation.

- Automatisation des flux : chaîner lecture d’emails, enrichissement, décision, puis action (création de compte, mise à jour CRM) sans recoder des règles complexes.

- Développement logiciel : corrections plus propres et vérifiées par tests, utile pour résorber la dette technique.

- Coûts et latence : baisse sensible sur les volumes simples grâce au raisonnement adaptatif et à la mise en cache d’invite.

Feuille de route d’adoption

À court terme, lancez deux pilotes : un chatbot interne (FAQ, support niveau 1) en Instant et une cellule d’analyse documentaire en Thinking. Mesurez précision, temps de réponse, satisfaction utilisateurs, puis comparez au coût total de possession (licences, appels API, gouvernance). En parallèle, outillez la traçabilité (journalisation, échantillons annotés), et formez les équipes aux nouveaux réflexes de rédaction de consignes.

Ensuite, étendez aux intégrations : connecteurs de messagerie et de calendrier, puis Zapier pour déclencher des actions dans vos outils. Côté sécurité, alignez les politiques d’usage, chiffrez les journaux et cadrez la conservation des prompts. Enfin, préparez un plan de continuité multi‑modèles : certains cas d’usage pourront mieux tourner sur des variantes mini, d’autres sur des modèles concurrents pour l’image ou la vision.

Conclusion : une IA plus proche du terrain

GPT‑5.1 marque un tournant pragmatique : une IA qui s’adapte au contexte, respecte les consignes et s’intègre aux applications. Pour les entreprises, le bénéfice n’est pas tant un score de benchmark qu’un triptyque mesurable : moins de latence, moins de reprises humaines, plus d’actions automatisées. Avec un marché très concurrentiel — OpenAI, Google, Anthropic — la stratégie gagnante sera modulaire : choisir le bon modèle pour chaque tâche, outiller la gouvernance, et industrialiser les gains là où ils sont prouvés.