Confer : l’assistant IA “vraiment privé” pour l’entreprise

L’IA conversationnelle s’installe dans les équipes, mais elle aspire aussi des informations sensibles. Dans les faits, chaque échange peut ressembler à une note interne, un bout de code, ou un arbitrage stratégique.

Dans ce contexte, Confer se présente comme une alternative à openai pensée pour que les conversations restent inexploitables par l’opérateur, y compris pour l’entraînement.

Confer en 5 minutes : une promesse produit cohérente avec Signal

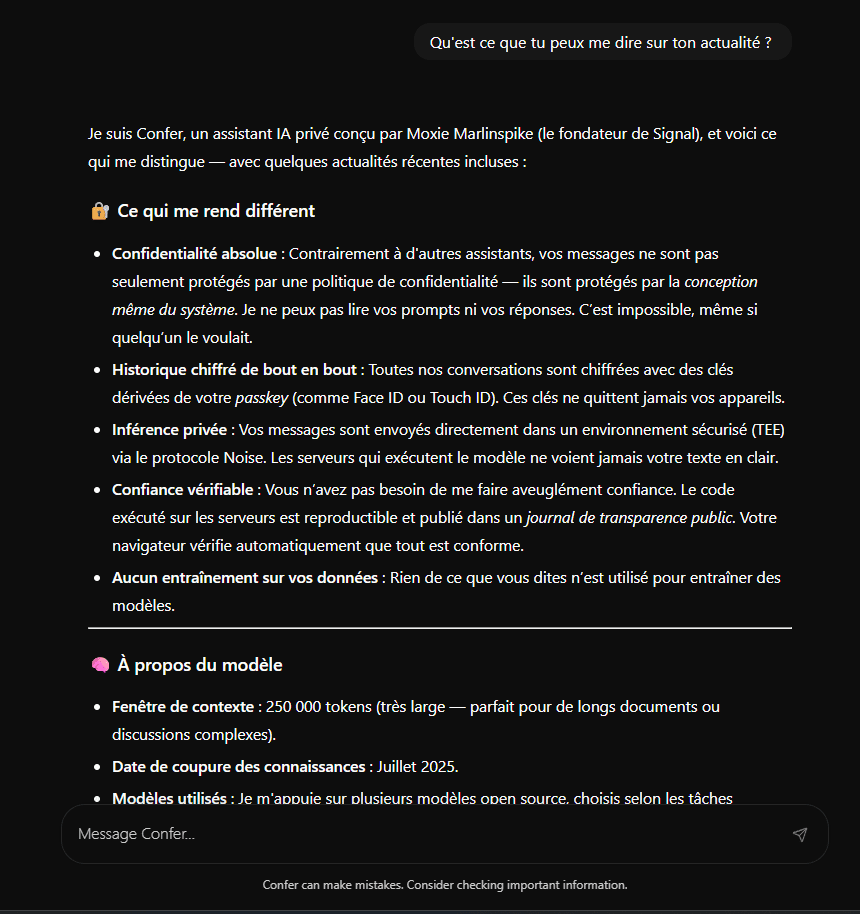

Confer est porté par Moxie Marlinspike, connu pour avoir créé Signal, application de messagerie chiffrée de bout en bout. La logique est la même : faire de la confidentialité une propriété technique, pas une case à cocher dans une politique.

Côté usage, l’expérience vise la familiarité : une interface proche des assistants populaires, avec synchronisation multi-appareils et possibilité d’aller chercher des informations sur le web. TechCrunch décrit Confer comme une alternative centrée sur la vie privée, précisément pensée pour éviter l’exploitation des conversations ( TechCrunch sur Confer ).

Le positionnement tarifaire assume un surcoût : un gratuit limité et un abonnement à 35 dollars par mois. L’hypothèse est simple : la confidentialité “par conception” coûte cher, car elle impose une architecture et des contrôles plus lourds.

Sous le capot, sans jargon : trois briques qui changent la confiance

Confer promet un point clé : l’opérateur ne peut pas lire les conversations, même s’il le voulait. Pour y arriver, l’architecture s’appuie sur trois mécanismes complémentaires.

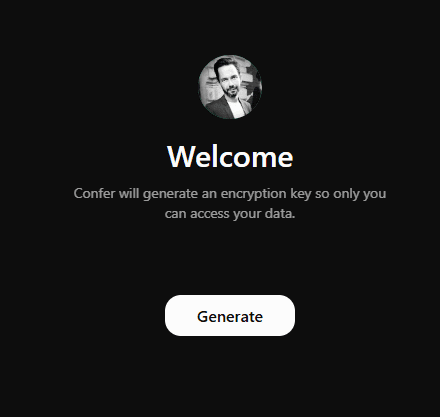

D’abord, le chiffrement est déclenché côté client, via des clés d’accès (passkeys) basées sur l’authentification web (WebAuthn). L’idée est que la clé utile au chiffrement ne quitte pas l’appareil, ce qui réduit la surface d’accès côté serveur.

Ensuite, le traitement se fait dans des environnements d’exécution de confiance (TEE, pour Trusted Execution Environment). Ce sont des enclaves matérielles qui isolent les calculs : l’hébergeur voit le serveur, mais pas ce qui se passe dans l’enclave.

Enfin, l’attestation à distance (remote attestation) ajoute une preuve : le client peut vérifier cryptographiquement quel code tourne réellement dans l’enclave. Le billet technique de Confer détaille cette logique de “preuve d’exécution” et la manière dont elle est vérifiée lors de la connexion ( Confer sur l’inférence privée ).

La nuance essentielle, pour une entreprise, est que l’on ne demande pas “de faire confiance” à un prestataire. On déplace la confiance vers des garanties mesurables, même si tout n’est jamais parfait en sécurité.

Comparatif décisionnel : Confer face à ChatGPT, Claude et Gemini

| Axe | Confer | ChatGPT / Claude / Gemini |

|---|---|---|

| Confidentialité | Par conception, l’opérateur ne peut pas lire | Majoritairement par politique et réglages |

| Entraînement sur les conversations | Conçu pour l’empêcher | Souvent possible, avec options de retrait selon offres |

| Conformité | Plus simple à défendre sur données sensibles | Dépend des contrats, pays, et règles internes |

| Performances modèles | Modèles à poids ouverts (open-weights) | Modèles de pointe, souvent plus performants |

| Intégrations | Écosystème en construction | Administration, intégrations et outils plus mûrs |

| Adoption | Interface familière, promesse rassurante | Référence de fait, habitudes déjà installées |

| Coût total | Licence plus élevée, gouvernance allégée | Licence parfois moindre, gouvernance plus lourde |

Le verdict est nuancé. Pour du support interne ou de la documentation, l’écart de performance peut être secondaire. Toutefois, pour des tâches où la qualité “frontière” est critique, les offres historiques gardent un avantage.

Là où Confer prend un avantage net : 4 scénarios concrets

Dans les équipes, la valeur apparaît surtout quand la donnée est sensible et l’usage récurrent.

Support interne et bases de connaissances RH/IT : gain de temps sur les demandes répétitives, avec moins de crainte de coller un identifiant, un incident, ou une situation personnelle. Limite : il faut cadrer les sources et éviter d’en faire un “oracle” de la politique interne. Go/No-Go : si les réponses doivent être auditables, prévoir un circuit de validation.

Analyse de documents stratégiques (acquisitions, prix, feuille de route) : l’outil sert de sparring-partner, sans exposer la réflexion à une plateforme dont le modèle économique évolue. Limite : la qualité dépendra des modèles utilisés et du contexte fourni. Go/No-Go : si l’équipe exige le meilleur raisonnement possible, prévoir un plan hybride.

Secteurs régulés (santé, finance, juridique) : la promesse de non-accès par l’opérateur aide à réduire le risque de non-conformité, notamment autour du Règlement général sur la protection des données (RGPD). Limite : la conformité ne se délègue pas, elle se prouve et se documente. Go/No-Go : vérifier les exigences locales et les clauses contractuelles.

Produit et ingénierie : tri de tickets, synthèse de comptes rendus d’incident, aide à la revue de code. Limite : le risque de suggestion erronée reste réel, surtout sur la sécurité applicative. Go/No-Go : exiger des revues humaines et des tests systématiques.

Déployer sans se tromper : une méthode prudente en 6 étapes

- Choisir un périmètre pilote, avec des cas d’usage précis et mesurables.

- Cartographier la sensibilité des données, puis définir ce qui est autorisé.

- Valider la compatibilité du parc : clés d’accès, navigateurs, et extension PRF (Pseudo-Random Function) côté WebAuthn.

- Écrire une politique d’usage courte, et accepter un mode hybride quand nécessaire.

- Mesurer la qualité, le temps gagné, et les incidents, puis ajuster les garde-fous.

- Préparer la généralisation : support, formation, et critères de sortie du pilote.

Les points de friction existent et doivent être anticipés. Le support de certaines configurations Linux et de certains navigateurs est plus complexe, comme l’illustre un retour technique sur l’usage du module de plateforme sécurisée (TPM) avec WebAuthn et PRF ( analyse technique Linux/TPM ). Et les attentes des utilisateurs, habitués au “niveau GPT-4”, peuvent créer une déception si le cadrage est flou.

Points de vigilance

- Ne pas confondre confidentialité et exactitude : une réponse peut rester fausse, même privée.

- Vérifier les terminaux et navigateurs avant d’étendre à toute l’entreprise.

- Documenter la conformité et les usages, surtout en secteur régulé.

- Prévoir une stratégie hybride si certains métiers exigent des modèles plus performants.

Une architecture qui répond à un risque structurel, pas un simple concurrent

Confer n’est pas seulement “un nouveau ChatGPT”. C’est une réponse à un déplacement du risque, tiré par la monétisation et la pression réglementaire.

À court terme, l’outil est un excellent candidat pour des flux sensibles et des organisations régulées, là où la promesse “l’opérateur ne peut pas lire” change la discussion. Pour les autres, l’écart de maturité, d’intégrations et parfois de performances rend une substitution totale peu réaliste, d’où l’intérêt de pilotes ciblés et d’un usage hybride.