Agents IA et Chatbot : quelles différences ?

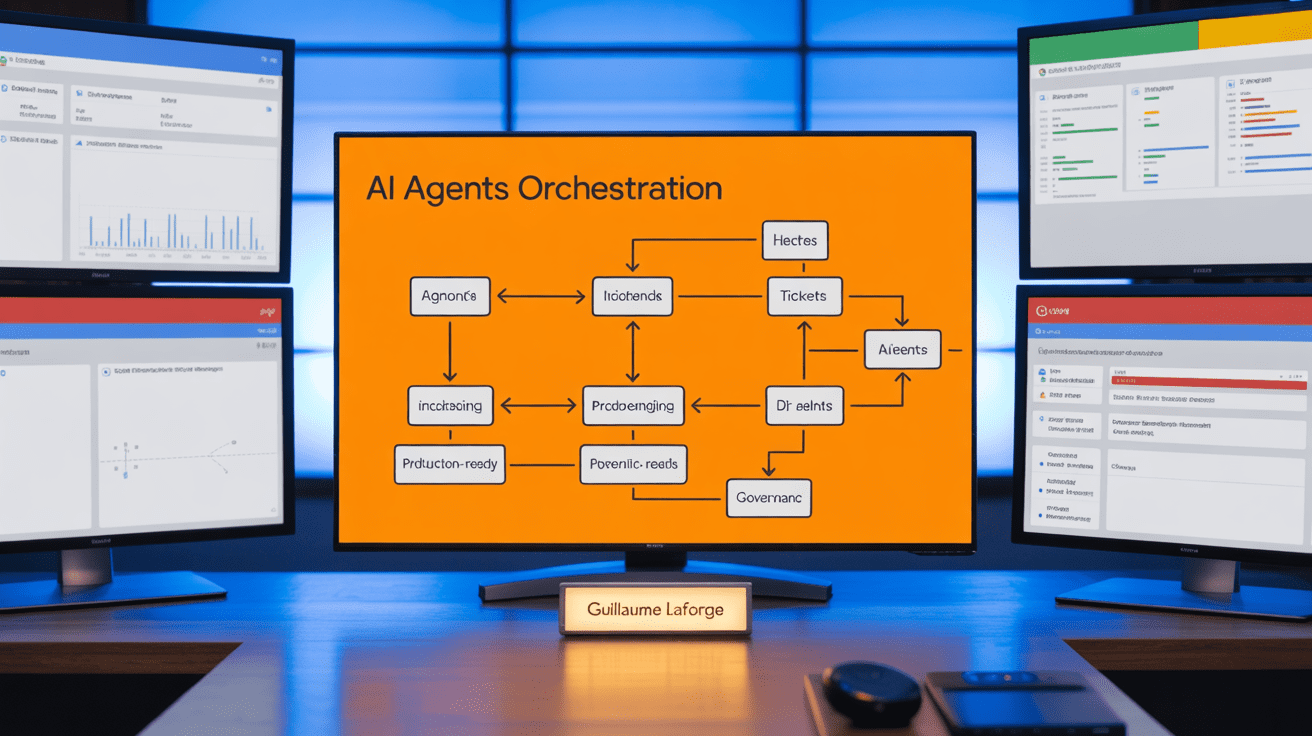

Un directeur des opérations demande à un assistant de clôturer un incident critique ; l’agent va diagnostiquer, créer un ticket, prévenir l’équipe et vérifier le rétablissement. Si l’IA se trompe, l’impact est immédiat sur le système et les clients. Dans ce contexte, Guillaume Laforge (Google Cloud) plaide pour une méthode d’ingénierie sobre, traçable et gouvernée, afin de passer de la preuve de concept (POC) au service en production.

Voici un cadre actionnable en plus de dix étapes, pensé pour managers produit, équipes data/plateformes et DevOps, afin de déployer des agents IA robustes, mesurables et économiquement viables.

Agents ≠ chatbots : ce qui change en entreprise

Un agent n’est pas un simple chatbot. Il planifie des actions, utilise des outils, conserve une mémoire et décide de manière autonome. Par rapport à un modèle de langage de grande taille (LLM), il peut enchaîner des étapes, accéder à des systèmes et s’adapter au contexte. Dans les faits, cela crée des effets en cascade : un mauvais choix d’outil peut modifier des données et déclencher d’autres traitements.

Côté usages, on voit des agents en service client, back-office et opérations informatiques (IT). Ils résolvent des tickets, orchestrent des tâches de conformité ou automatisent des relances fournisseurs. En pratique, les pièges d’adoption sont connus : périmètre trop large, orchestration inutilement complexe et manque de garde-fous. Le message clé de Laforge : privilégier le pragmatisme d’ingénierie plutôt que les démonstrations spectaculaires.

Ia : trois principes fondateurs de robustesse

Simplicité ciblée. Un agent = un objectif clair. On ajoute de la complexité uniquement si les données prouvent que c’est nécessaire. Les gains sont immédiats en fiabilité, maintenance et coûts. Les recommandations d’Anthropic insistent sur des agents simples, focalisés et extensibles par itérations mesurées ( guides Anthropic sur les agents ).

Transparence et traçabilité. Rendre visibles les étapes de planification, les choix d’outils et les sorties intermédiaires. Cela renforce la confiance, facilite l’audit et accélère le débogage. Dans ce contexte, investir tôt dans le traçage d’exécution est payant.

Humain dans la boucle (human‑in‑the‑loop) dès la conception. On exige des confirmations avant toute action irréversible ou coûteuse, on prévoit des escalades et on ferme le cycle avec des retours utilisateurs. À court terme, ces garde-fous limitent les risques et fournissent des données pour l’amélioration continue.

À embarquer dès J1 : un périmètre fonctionnel précis, des critères de succès explicites, des seuils d’escalade documentés et une journalisation systématique des décisions de l’agent.

Patterns d’orchestration multi-agents : choisir le bon outil

Séquentiel et transfert (handoff). Un pipeline clair où chaque agent a un rôle ; avec transferts dynamiques quand le contexte l’exige. À utiliser pour des flux de travail stables, avec métriques de succès sur le temps de traversée et le taux de résolution au premier passage.

Parallèle/concurrent. Plusieurs agents travaillent en même temps afin de réduire la latence ou croiser des perspectives. Utile quand le délai est critique ou quand l’analyse gagne à la diversité. Le coût et la coordination augmentent ; on mesure la latence globale et la couverture du problème.

Discussion de groupe (group chat) et collaboration. Un « chef d’orchestre » coordonne des spécialistes qui débattent, valident et synthétisent. Pertinent pour le brainstorming structuré et les revues. Anti-pattern classique : discussions sans clôture ; on ajoute alors des règles d’arrêt et des critères de décision.

Hiérarchique. Décomposition du haut vers le bas, spécialisation par niveau et confinement des erreurs. Idéal pour des processus complexes avec sous-domaines distincts. On suit le taux de réussite par niveau et la qualité d’agrégation des résultats.

Pour un panorama d’architectures et de compromis, la documentation Microsoft Azure détaille des schémas d’orchestration et leurs impacts opérationnels ( référence Azure AI Studio ).

Excellence du design des outils (tools)

Un outil doit avoir un but distinct. Sa description précise les paramètres, types, contraintes, exemples et erreurs attendues. Des réponses frugales en jetons (tokens) réduisent les coûts : on privilégie des résumés, la pagination et des formats structurés indiquant le statut, les métadonnées et les « prochaines étapes » possibles. On délègue les traitements déterministes au code ou à l’interface de programmation (API) — calculs, validations, formats — plutôt qu’au LLM, qui reste probabiliste.

Anthropic montre que la qualité de la spécification d’un outil influence directement la performance de l’agent, autant que son nombre ou sa variété ( conseils de conception d’outils ).

- Check-list Do/Don’t de spécification d’outils : nom explicite ; paramètres typés avec exemples valides et invalides ; messages d’erreur normalisés ; pagination et limites claires ; réponses structurées et concises ; interdiction des effets de bord non documentés.

Évaluation et assurance qualité (QA) : tester plus que la sortie finale

On évalue par composant : routage, extraction de paramètres, récupération d’information, pertinence du contexte, exécution d’outil et cohérence du raisonnement. Les jeux de tests couvrent cas de succès, bords, refus attendus et scénarios adversariaux ; à partir d’une trentaine de cas par agent, on obtient une signifiance minimale. L’évaluation par modèle (LLM-as-judge) fonctionne à condition d’employer des rubriques claires, des exemples et un modèle distinct de celui qui produit la réponse. Des guides pratiques détaillent ces approches, dont Arize et Confident AI ( guide Arize sur l’évaluation des agents, guide Confident AI ).

Les indicateurs à suivre incluent le taux d’achèvement, la précision des appels d’outils, la dérive d’instructions, la détection de boucles infinies et les faux positifs de réussite.

Observabilité et monitoring continus

Le traçage d’exécution dépasse les journaux. Il relie chaque décision à son contexte : raisonnement, appels d’outils, données consultées et résultats intermédiaires. En pratique, les tableaux de bord suivent latence, erreurs, coûts en jetons, dérive de qualité et fréquence des escalades. On lance des évaluations sur trafic réel, on alerte à la régression et on conserve les traces pour audit et analyse des causes racines (RCA).

L’intégration à la gouvernance est essentielle : politiques d’accès, approbations pour actions sensibles, auditabilité systématique. Des recommandations opérationnelles sont disponibles dans la documentation Azure sur l’évaluation et le monitoring ( évaluer et surveiller dans Azure AI Studio ).

Gestion des erreurs et dégradation gracieuse

On commence par cartographier les modes de défaillance et par installer des garde-fous proactifs. Les réactions sont contextuelles : on priorise par impact et on communique clairement aux utilisateurs. Les capacités d’auto-réparation incluent des réessaies contrôlés, des stratégies de repli, le redémarrage de sous-tâches et des limites pour éviter l’amplification des erreurs. Des exercices de chaos engineering et de reprise après sinistre (DR) valident régulièrement les scénarios de repli.

Coûts et right-sizing des modèles

Les métriques clés sont le coût par jeton, le volume d’appels, l’efficience modèle/qualité, le taux d’utilisation des jetons et le coût par résultat métier. Les optimisations comprennent des invites concises, la mise en cache, le traitement par lots et le routage vers de petits modèles pour des tâches simples, en réservant les plus puissants au raisonnement. Des garde-fous budgétaires fixent des budgets par agent, des alertes d’excès et des tests A/B (A/B testing) pour arbitrer coût/qualité.

Sécurité, gouvernance et conformité

Chaque agent dispose d’une identité propre avec des permissions minimales. C’est la « confiance nulle » (Zero Trust) : on vérifie en continu l’identité, la légitimité de la requête et l’alignement avec la politique. Contre les injections d’invite, on ajoute des instructions explicites, du filtrage et des approbations humaines pour les actions sensibles, en complément du red teaming. OpenAI recense des bonnes pratiques utiles à ce sujet ( défense contre les prompt injections ). Pour réduire les hallucinations, on utilise la génération enrichie par récupération (RAG), on vérifie les sources et on impose des seuils de confiance, avec escalade sur les domaines à haut risque.

Mémoire et apprentissage en continu

La mémoire se superpose en couches. Un tampon conversationnel garde le contexte récent ; un rappel historique permet d’interroger les échanges passés ; une mémoire épisodique enregistre les exécutions ; une mémoire sémantique stabilise les connaissances. Les boucles de feedback séparent réflexion et exécution ; des tests de régression précèdent toute mise à jour pour éviter la régression. On prévient le « détournement de récompense » en mélangeant des notations humaines et des signaux variés, et on gouverne les mises à jour de mémoire : qui écrit, quand et selon quels contrôles de qualité.

Passage à l’échelle : de l’agent au programme d’entreprise

On industrialise par domaines : des agents spécialisés par métier, avec modèles et outillage adaptés. Côté organisation, on met en place une escouade transverse produit–plateforme–sécurité–juridique–métiers, avec une matrice responsable, autorité, consulté, informé (RACI) claire. À 30 jours, un pilote focalisé prouve la valeur ; à 60 jours, on durcit l’évaluation, l’observabilité et la sécurité ; à 90 jours, on étend à plusieurs domaines avec les mêmes standards.

Les leçons de Guillaume Laforge

Trinité pragmatique : simplicité d’architecture, outils déterministes bien documentés, observabilité de bout en bout. Empilement cloud-natif avec services managés et sans serveur (serverless), traçage et métriques par défaut, intégration à l’intégration et déploiement continus (CI/CD) et à des tests d’agent. Culture d’ingénierie : itérer petit mais vite, toujours instrumenté et mesuré.

Stack de référence (exemple Google Cloud)

Exécution avec Cloud Run ou GKE pour héberger des services d’agents ; IA avec Vertex AI pour les modèles, la RAG et l’évaluation, plus du routage d’endpoint ; orchestration avec publication/abonnement (Pub/Sub) pour les événements et Workflows pour les séquences ; observabilité avec Cloud Logging, Cloud Trace et Error Reporting, plus des tableaux de bord dédiés aux agents ; sécurité via gestion des identités et des accès (IAM) fine, Secret Manager, périmètres de service (VPC Service Controls) et journaux d’audit.

Conclusion actionnable

Trois décisions cette semaine. D’abord, cadrer un agent mono-objectif avec critères de succès mesurables. Ensuite, instrumenter un traçage complet et constituer au moins 30 cas de tests. Enfin, exiger des approbations humaines pour toute action sensible. Objectif : prouver la fiabilité sur un périmètre étroit, puis étendre progressivement avec mesure, gouvernance et contrôle des coûts.