IA: le pari du modèle frugal bouscule les coûts

Un virage IA qui rebat les cartes des coûts et de l’infrastructure

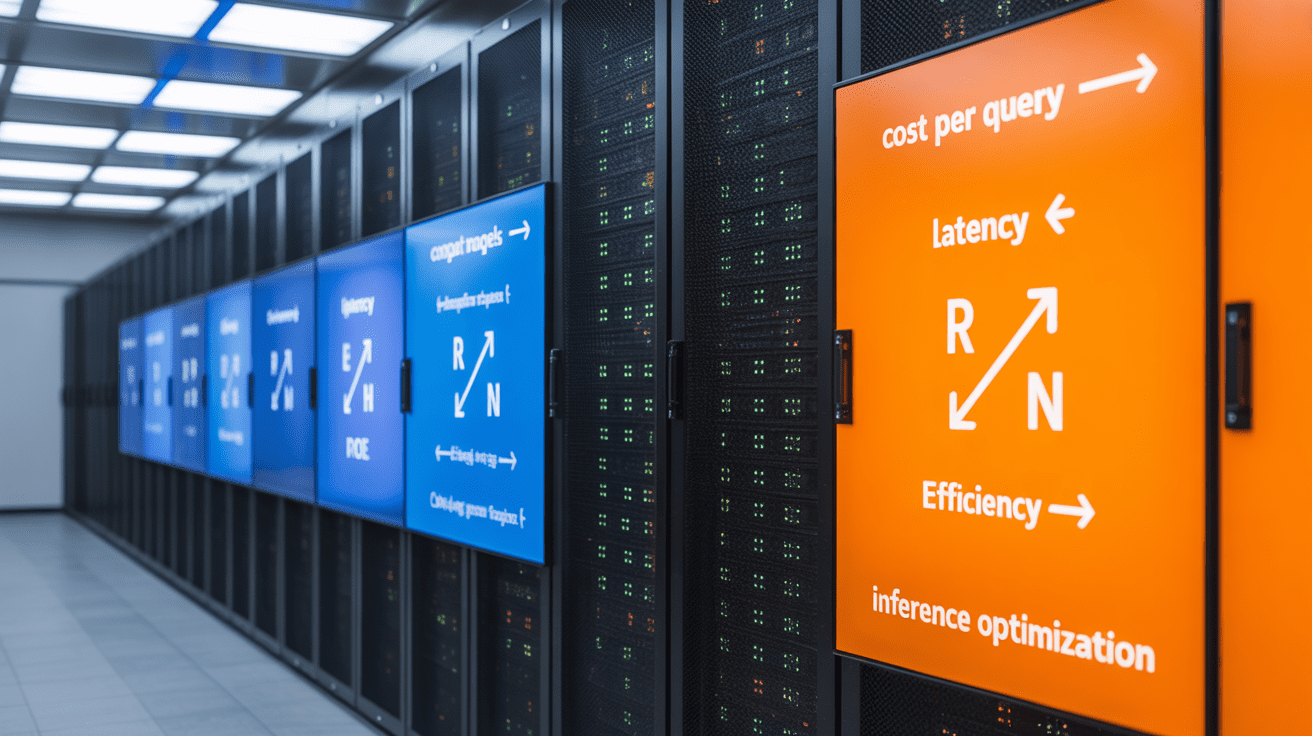

L’intelligence artificielle (IA) traverse un tournant stratégique: la logique du « toujours plus grand » cède la place à des modèles plus frugaux et adaptatifs. Au-delà du débat technique, l’enjeu est concret pour les entreprises: réduire le coût par requête, la latence et la dépendance aux processeurs graphiques (GPU). Ce déplacement du centre de gravité — du changement d’échelle (scaling) à l’efficacité — appelle des choix rapides de fournisseurs, de contrats et d’architecture.

Cohere change de cap, le débat s’installe dans l’écosystème

À l’été 2025, Sara Hooker, ex‑responsable recherche de Cohere, a publicisé une critique argumentée de l’hypercentralité du changement d’échelle. Son message: la puissance de calcul n’est pas un proxy fiable de valeur métier, ni de risque, et l’on sous‑investit des pistes plus sobres. Dans le même temps, l’arrivée de Joelle Pineau à la direction scientifique de Cohere a clarifié l’orientation: privilégier des cas d’usage d’entreprise, avec une exigence d’efficacité et de cycles plus courts.

Dans les faits, plusieurs avancées soutiennent ce virage. D’abord, la qualité des données: des travaux académiques montrent qu’un corpus mieux filtré peut compenser une baisse de volume, avec des gains nets sur les coûts et l’énergie. L’initiative DataComp illustre ce point en comparant des jeux de données épurés à des masses brutes plus volumineuses, au bénéfice des premiers ( DataComp sur arXiv ). Ensuite, l’économie d’inférence a été bouleversée: quantification (quantization), élagage (pruning) et distillation des connaissances (knowledge distillation) ont fait chuter les coûts par génération sans entraîner de ré‑entraînement massif. Le rapport AI Index 2024 de Stanford documente une baisse spectaculaire du coût d’inférence pour des performances de type GPT‑3.5 entre fin 2022 et 2024 ( AI Index 2024 ).

Autre levier: les architectures à mélange d’experts (MoE), qui n’activent qu’une fraction des paramètres à l’inférence tout en maintenant un haut niveau de capacité. L’idée, popularisée notamment par les Switch Transformers de Google, est d’utiliser des experts spécialisés avec un mécanisme de routage ( Switch Transformer, arXiv ). Résultat: latence et coût proches de modèles plus petits, avec des performances qui rivalisent sur des tâches complexes.

Pourquoi ce virage IA compte pour DSI, achats et finance

Côté entreprises, l’impact se lit sur quatre lignes budgétaires et opérationnelles. D’abord, le coût total de possession (TCO) de l’IA: si un grand modèle de langage (LLM) peut être remplacé par un modèle plus petit bien post‑entraîné, optimisé pour l’inférence et correctement mis en cache, le coût par requête et la facture énergétique baissent immédiatement. Ensuite, la latence: des techniques comme la quantification à l’inférence et la réduction contextuelle des entrées ramènent des temps de réponse au bon niveau utilisateur, sans GPU supplémentaires.

Troisième enjeu, l’empreinte d’infrastructure: des modèles et des pipelines d’inférence plus économes utilisent mieux des GPU déjà en place et repoussent des achats de cartes haut de gamme. Cela rend des scénarios hybrides (sur site et cloud) plus soutenables, en réallouant la dépense depuis la pré‑formation vers l’optimisation post‑entraînement et l’orchestration. Enfin, la gouvernance: la loi européenne sur l’intelligence artificielle (AI Act) rapproche le débat technique de la conformité et de la souveraineté des données. Des architectures efficaces et plus localisables aident à maîtriser où transitent les flux et comment ils sont journalisés, un point valorisé par la Commission européenne ( Approche européenne de l’IA ).

Concrètement, les critères d’achat bougent. Les benchmarks génériques et les classements abstraits importent moins que le coût par requête, la latence sous charge et la capacité à faire tourner plusieurs modèles par serveur en continu. La notion de preuve de concept (PoC) devient centrale: il faut comparer, sur un jeu de tâches métier, un LLM « gonflé » et une chaîne optimisée mêlant modèle plus petit, quantification, cache, et éventuellement mélange d’experts.

Ce que disent les chiffres et les architectures, au‑delà du slogan

Les signaux convergent. Côté données, le tri, la déduplication et la priorisation d’annotation permettent d’atteindre la même performance avec nettement moins de données et de calcul, réduisant la pression sur les GPU. Côté inférence, l’empilement de techniques éprouvées — quantification, élagage, distillation, cache d’entrées et d’activations, optimisation de la longueur des prompts — aboutit à des gains de 5 à 10 fois sur le rapport prix‑performance dans des déploiements réels, sans changer de famille de modèle.

Les architectures à mélange d’experts (MoE) apportent une autre réponse à l’impasse du « tout dense ». Plutôt que d’activer 100 % des paramètres à chaque token, un réseau de routage aiguillage des séquences vers quelques experts spécialisés. On garde la polyvalence d’un grand modèle, mais on ne paye qu’une fraction de l’addition à l’inférence. Pour les équipes, cela ouvre la voie à des modèles plus ambitieux qui restent déployables avec une latence maîtrisée.

Le déplacement financier vers le post‑entraînement change aussi la donne. Là où la pré‑formation dominait les budgets, on observe un transfert vers l’ajustement fin des modèles pour des tâches ciblées, qu’il s’agisse d’apprentissage supervisé, d’optimisation directe des préférences (DPO) ou d’auto‑retours générés par l’IA. Même les acteurs de pointe, à l’image d’OpenAI avec sa série o1, expliquent désormais que la qualité de la « boucle de raffinement » pèse lourdement dans la capacité pratique ( OpenAI o1, blog ). Pour l’entreprise, cela signifie qu’une part accrue de la valeur se joue dans les données propres, l’instrumentation et les boucles d’amélioration continue, pas dans la seule location de GPU.

Reste la question d’infrastructure. Le talon d’Achille des déploiements IA est la sous‑utilisation chronique des GPU, souvent coincés par des orchestrations rigides et des goulots d’étranglement côté CPU. Des plateformes d’ordonnancement moderne et des « brokers » de calcul réallouent les ressources dynamiquement, augmentant le taux d’occupation utile sans racheter de matériel. À l’échelle d’un parc, quelques points de pourcentage de mieux en utilisation peuvent faire décaler de trimestres des investissements et améliorer le TCO.

Sur le nuage comme sur site, les arbitrages évoluent. Des analyses indépendantes de TCO montrent que, pour des charges stables et bien orchestrées, l’option sur site peut redevenir compétitive en deux à trois ans, surtout si la montée en efficience retarde des rafraîchissements matériels. À l’inverse, pour des charges irrégulières, le cloud reste pertinent, d’autant que les instances ponctuelles et les engagements multi‑annuels font baisser la facture. L’essentiel est de coupler ces arbitrages à des métriques opérantes: coût par requête, modèles par serveur, et kWh par 1 000 requêtes — pas seulement des pics de performances théoriques.

Côté conformité et souveraineté, l’anti‑gaspillage computationnel devient un allié. Des modèles plus sobres et des pipelines d’inférence localisables facilitent le respect des exigences de localisation de données et limitent les transferts transfrontaliers non nécessaires. Ils réduisent aussi l’empreinte énergétique, un sujet de plus en plus examiné par les directions RSE et les financeurs.

Points de vigilance:

- Mesurer en production: le coût par requête varie fortement selon la longueur des entrées, le cache et les pics de charge.

- Lissage des risques: mixer modèles frugaux et un LLM plus large pour les cas complexes permet de garder la qualité perçue.

- Contrats: prévoir des clauses de sortie et de portabilité des poids et jeux de données d’entraînement.

- Sécurité et gouvernance: tracer qui utilise quel modèle, où résident les logs et comment sont gérés les prompts sensibles.

Comment décider sans dogme: grille de lecture pratico‑pratique

La bonne question n’est pas « grand modèle ou petit modèle », mais « quel service au bon coût et à la bonne latence pour cette tâche ». Pour des assistants internes, de la classification documentaire ou des extractions structurées, des modèles plus petits post‑entraînés et quantifiés suffisent souvent, avec des latences sous la seconde. Pour des cas à forte complexité et forte incertitude, un LLM plus puissant en secours, appelé selon des règles de routage, amortit le risque qualité sans faire exploser les coûts.

Évitez les comparaisons en laboratoire déconnectées des charges réelles. Utilisez un protocole commun: mêmes documents, mêmes formats, mêmes contraintes de délai, mêmes métriques. Testez une architecture « frugale d’abord »: modèle compact spécialisé, cache agressif, quantification, et si possible un MoE. Comparez au LLM généraliste « dense » du marché. Mesurez coût par requête, latence P95, taux d’occupation GPU, et taux d’erreur métier utile (par exemple, taux de champs extraits corrects). Les enseignements tirés de ces PoC structurent ensuite le choix de fournisseurs et la trajectoire d’infrastructure.

Les précédents historiques sont éclairants. Quand l’informatique a migré du « mainframe » au client‑serveur, puis au cloud, les gagnants ont été ceux qui ont aligné architecture, métriques et contrats. L’IA n’échappe pas à cette règle: l’adéquation fine entre modèle, données, inférence et orchestration vaut plus qu’un record ponctuel de benchmark. Les travaux académiques sur la qualité des données et les architectures MoE, ainsi que les données publiques de l’AI Index, convergent pour indiquer que l’efficacité est désormais le principal multiplicateur de valeur.

À retenir et à agir en 90 jours

L’ère de l’IA frugale est une opportunité concrète de réduire les coûts et les délais sans sacrifier la qualité perçue. Priorité: lancer une preuve de concept comparant une chaîne « frugale d’abord » à un LLM dense sur vos cas d’usage critiques. En parallèle, renégociez les contrats et ajustez le plan GPU/cloud à la lumière d’indicateurs opérationnels: coût par requête, latence et souveraineté des données.